La parade des véhicules autonomes gâchée par la pluie

D'après les dires d'Elon Musk, Tesla prévoit d'implémenter la conduite autonome en utilisant uniquement des caméras pour voir ce qui se passe. L'approche de Tesla contraste avec ce que fait le reste du secteur automobile. La plupart des procédés de conduite autonomes dépendent d'un mélange de caméras, de radars et de lidars pour voir ce qui se trouve sur la trajectoire d'un véhicule. La raison de cette approche à plusieurs capteurs ? On a tendance à croire que seule une combinaison de plusieurs technologies de capteurs est capable de comprendre des scénarios que des technologies de détection spécifiques ne trouvent pas clairs.

Étant donné la position de Tesla en ce qui concerne la détection par caméra, il est intéressant d'étudier quelques-uns des problèmes qui affectent les capteurs des véhicules autonomes malgré des années de tests et de recherches. Prenons tout d'abord les caméras. Exemple classique de scénario problématique : un véhicule arrive en haut d'une colline avec en face de lui le soleil couchant. La lumière vive du soleil aveugle momentanément la caméra, tout comme elle le ferait avec un conducteur humain. Lorsque le véhicule descend la colline pour rejoindre une vallée plongée dans la pénombre, la caméra peut également être momentanément aveuglée le temps de s'adapter à l'obscurité relative.

Il existe aussi des « cas extrêmes » susceptibles de désorienter les caméras, mais pas les autres types de capteurs. Dans le jargon de l'intelligence artificielle, ces cas extrêmes décrivent des situations singulières qui se produisent dans la vraie vie et que les algorithmes d'apprentissage automatique n'ont jamais rencontrées. L'exemple classique d'un cas extrême qui peut déboussoler des capteurs de caméra est celui du décor peint à l'arrière d'un camion. La caméra installée sur la voiture qui suit le camion peut ne pas comprendre que le décor n'est qu'une peinture.

Il y a peut-être des moyens de contourner ces difficultés en utilisant uniquement une technologie de caméra : l'ajout d'une caméra infrarouge pourrait par exemple contribuer à résoudre le problème. Mais il y a un autre obstacle qui affecte les caméras et les autres capteurs pour la conduite autonome : le mauvais temps.

(Source de l'image : Littelfuse)

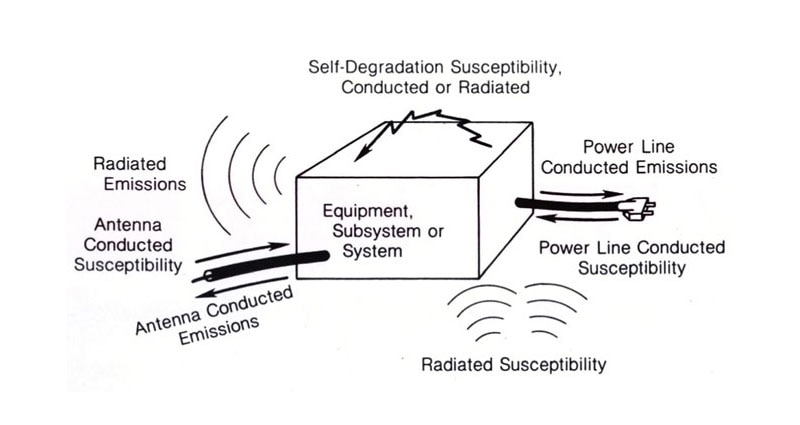

(Source de l'image : Littelfuse)

Une seule goutte d'eau (ou un seul flocon de neige) à un endroit stratégique sur un objectif peut paralyser une caméra. Les gouttes de pluie qui ne touchent pas l'objectif peuvent tout de même produire des variations d'intensité dans les images et ainsi compliquer le processus d'identification des obstacles. Plus particulièrement, chaque goutte bloque une partie de la lumière qui serait sinon réfléchie par les objets en vue. La pluie réduit également le contraste global de la scène. Lors de tests réalisés à l'Université d'État du Michigan il y a quelques années, des chercheurs ont découvert que les algorithmes basés sur des caméras ne parvenaient pas à détecter 20 % des objets sous une pluie de faible intensité. Sous une pluie plus intense, ce taux grimpait jusqu'à 40 %.

Il existe des algorithmes de suppression de la pluie conçus pour aider les systèmes basés sur des caméras à détecter les objets. Mais pour l'instant, ils ne fonctionnent pas bien. Une raison explique ce dysfonctionnement : ces algorithmes ont principalement été testés sur de la pluie artificielle, qui est beaucoup moins complexe que la réalité.

Les radars et les lidars présentent leurs propres problèmes en ce qui concerne la navigation sous la pluie ou la neige. Cela s'avère facilement explicable. Ces deux mécanismes de détection dépendent de la réflexion transmise par les objets pour localiser et identifier ce qu'il y a devant. Lorsque la réflexion est transmise par des gouttes de pluie ou des flocons de neige, il est difficile de dire ce qu'il y a derrière la neige ou la pluie.

Il s'avère que la pluie de faible intensité ne perturbe pas beaucoup les lidars. Mais la pluie intense peut former des masses qu'un capteur lidar peut interpréter comme étant des obstacles. Par ailleurs, des tests ont montré que les projections des autres véhicules après de fortes pluies pouvaient créer de fausses cibles lidars. (Ceux qui veulent avoir un aperçu de ce problème peuvent suivre un poids lourd à 18 roues sur l'autoroute pendant un orage.) Il en va de même pour la neige. Les données de test sur le comportement des lidars en cas de neige sont rares, mais tendent à indiquer que la neige peut empêcher les lidars de voir des objets ou créer de faux retours. Par exemple, un test réalisé en Finlande et en Suède a démontré que les tourbillons de neige comme ceux générés par une voiture qui vous précède pouvaient brouiller les mesures d'un lidar.

Les radars s'en sortent mieux que les lidars sous la pluie et la neige. La neige fondue semble causer le plus de problèmes. Le plus gros inconvénient des radars par temps pluvieux semble être une moins bonne capacité à détecter des objets avec une surface équivalente radar plus petite, comme des piétons.

Bien entendu, la détection pour les véhicules autonomes par mauvais temps fait toujours l'objet de recherches. Une approche en cours d'examen utilise deux capteurs au lieu d'un seul pour détecter les objets. Si l'un des capteurs détecte un objet alors que l'autre ne le détecte pas, des opérations mathématiques sophistiquées essaient de déterminer lequel a raison. Les constructeurs automobiles ne se réjouissent probablement pas de ce procédé spécifique, car il augmente le nombre de capteurs présents sur le véhicule, mais d'autres approches sont également au centre de l'attention.

Les constructeurs automobiles finiront certainement par se frayer un chemin dans toutes les conditions météo. Une variante d'une vieille citation pourrait alors devenir une réalité, du moins en ce qui concerne les véhicules : le mauvais temps n'existe pas, il ne s'agit que de différents types de temps pour conduire.

Have questions or comments? Continue the conversation on TechForum, DigiKey's online community and technical resource.

Visit TechForum