Einsatz von Infrarot- und Laufzeit-Bildtechnik zur Erweiterung der Robotikfähigkeiten

Zur Verfügung gestellt von Nordamerikanische Fachredakteure von DigiKey

2016-05-19

Für viele Robotikanwendungen ist die Bildtechnik von entscheidender Bedeutung: Sie ermöglicht Robotern die Ausführung grundlegender Aufgaben, die Umgehung von Hindernissen, das Navigieren und die Gewährleistung der grundsätzlichen Sicherheit. Der offensichtliche Weg der Bildgebung ist eine kostengünstige Videokamera. Besser noch wären zwei Kameras für ein Stereosehen und die Tiefenwahrnehmung. Allerdings weist die letztgenannte Option zahlreiche Nachteile auf.

Mit dem Einsatz von zwei Kameras für die 3D-Bilderzeugung steigen Stromverbrauch und Platzbedarf. Außerdem verkomplizieren zwei Kameras den Formfaktor und den Fertigungsprozess und erhöhen die Kosten. Mit dem zunehmend alltäglichen Einsatz der 3D-Bildtechnik in Anwendungen, die sich von einfachen „Assistentengeräten“ bis hin zu autonomen Fahrzeugen erstecken, benötigen Konstrukteure eine bessere Alternative als einfach nur noch mehr Kameras hinzuzufügen.

Aus diesem Grund nutzen Konstrukteure im wachsenden Maß solche Alternativen, die Vorteile in Bezug auf Gehäusegestaltung, Kosten, Stromverbrauch, Datenreduzierung und Gesamtleistung bieten. Zu diesen Alternativen zählen die Laufzeit- (Time-of-Flight-) oder kurz ToF-Bildgebungssysteme, die oft auch mit dem Begriff „LIDAR“ für „Light Detection and Ranging“ bezeichnet werden. Diese Alternativen können durch Infrarot- oder IR-Bildtechnik ergänzt werden, die oft mit dem Begriff „Thermografie“ bezeichnet wird.

Der Start mit IR

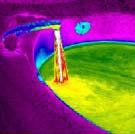

Elektromagnetische Wellen im Infrarot-Bereich haben Wellenlängen, die jenseits der Wellenlängen am roten Ende des sichtbaren Lichtspektrums beginnen. Die Wellenlängen des IR-Bands liegen im Allgemeinen zwischen 700 nm (0,7 µm) und 1 mm (1000 µm). Ganz einfach ausgedrückt entsprechen sie der Wärme, die von einem Objekt abgestrahlt wird. Mit einem geeigneten IR-Bilderfassungssystem wird diese „Wärmekarte“ des IR-Bereichs in ein Bild im Bereich des sichtbaren Lichts umgewandelt, wobei oftmals Falschfarben hinzugefügt werden, um die relativen Temperaturen hervorzuheben (Abbildung 1).

Abbildung 1: Ein Infrarot-Bild von Wasser, das aus einem Wasserhahn in ein Waschbecken läuft. Beachten Sie die Verwendung von „Falschfarben“ zur besseren Darstellung der Temperaturunterschiede. (Bild mit Genehmigung von FLIR Systems, Inc.)

Beachten Sie, dass die IR-Bildgebung etwas anderes ist als die IR-Messung. Die Messung ist ein kontaktloses Verfahren zum Aufspüren und sogar Messen einer Wärmequelle, etwa eines Menschen, der an einem passiven Infrarot- oder PIR-Sensor vorübergeht, der zu einer Alarmanlage gehört, oder zum Überwachen von Rohrleitungen auf Überhitzung. Es gibt dabei kein bildartiges Detail und keine Bildauflösung.

Warum IR anstelle oder als Ergänzung zur herkömmlichen Bilderfassung mit sichtbarem Licht einsetzen? Es gibt hierfür mehrere Gründe:

- IR ist dort wertvoll, wo die Objekte von Interesse mit ihrem Hintergrund verschmelzen, sei es als bewusste Tarnung oder einfach nur zufällig.

- IR kann Personen oder warmblütige Tiere im Sichtfeld aufspüren.

- IR ist auch dort hilfreich, wo allgemeine Fehler aufgespürt werden sollen, wie zum Beispiel überhitzte Rohre und Dampfleitungen, Schwelbrände oder elektrische Fehlfunktionen, die zur örtlich begrenzten Erhitzung führen können.

Der Einsatz eines Untersystems zur IR-Bildgebung ist jetzt erheblich vereinfacht – durch hochintegrierte und enorm leistungsfähige Komponenten mit anwenderfreundlichen Schnittstellen. Sehen wir uns zum Beispiel einmal die Lepton IR-Kamera von FLIR Systems, Inc. an (Abbildung ). Sie ist ungefähr 10 × 12 × 6 mm groß, enthält eine Linsenbaugruppe mit festem Fokus, ein 80 × 60 Pixel großes Langwellen-Infrarot (LWIR) Mikrobolometer-Sensor-Array für 8 bis 14 μm IR sowie die Elektronik zur Signalverarbeitung.

Abbildung 2: Der Lepton-Bildgeber von FLIR (dargestellt ohne Sockel) ist eine hochintegrierte Einheit, die neben der Signalverarbeitung auch anwenderprogrammierbare Funktionen enthält. (Bild mit Genehmigung von FLIR Systems, Inc.)

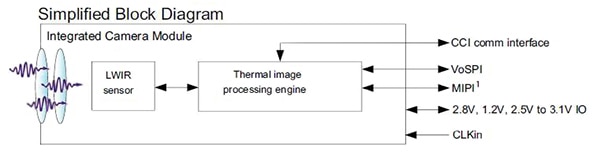

Die Einbindung wird durch Verwendung von MIPI- und SPI-Videoschnittstellen nach Industriestandards sowie der zweiadrigen I2C-ähnlichen seriellen Steuerungsschnittstelle vereinfacht (Abbildung 3). Trotz ihrer geringen Größe und Anwenderfreundlichkeit weist die Lepton-Einheit beachtliche Leistungswerte auf: eine schnelle Bilderzeugung von weniger als 0,5 Sekunden und eine thermische Empfindlichkeit von unter 50 mK. Auch die Leistungsaufnahme im Betrieb ist gering und liegt bei 150 mW (typisch).

Abbildung 3: Das vereinfachte Blockschaltbild der Lepton-Einheit zeigt dessen integrierte Bildverarbeitungseinheit zusätzlich zum grundlegenden Sensor-Array sowie seine einfache Schnittstelle zum Benutzersystem. (Bild mit Genehmigung von FLIR Systems, Inc.)

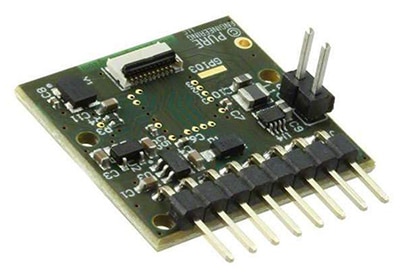

Produkte wie dieses profitieren von praktischer Anwendererfahrung, weshalb FLIR eine Breakout-Karte für das Kameramodul anbietet, die mit ARM-basierten Evaluierungskarten und dem Raspberry Pi kompatibel ist (Abbildung 4). Diese 25 mm × 24 mm große Karte benötigt eine einzelne 3- bis 5,5-V-Spannungsversorgung und enthält einen 25-MHz-Systemtaktgeber, interne LDOs für zusätzliche rauscharme Stromschienen sowie eine 32-polige Molex-Steckleiste für das eigentliche Lepton-Modul.

(a)

(b)

Abbildung 4: Die Lepton-Breakout-Karte (a) (abgebildet ohne Lepton-Einheit) ermöglicht Konstrukteuren die Evaluierung und Programmierung der Einheit mithilfe verschiedener Evaluierungskarten, was dank Standardsteckverbinder und Schnittstelle (b) möglich wird. (Bilder mit Genehmigung von FLIR Systems, Inc.)

ToF nimmt an Fahrt auf

Für viele Anwendungen ist ein Thermobild zwar nützlich aber unzureichend, und es wird ein Bildgebungssystem im sichtbaren Lichtbereich benötigt, oftmals in 3D. Die naheliegende Lösung ist die Verwendung einer standardmäßigen Videokamera, wie sie inzwischen von zahlreichen Anbietern und mit unterschiedlichsten Auflösungen, Lichtempfindlichkeiten, Größen und Schnittstellenoptionen angeboten werden. Falls ein Stereobild benötigt wird, nimmt man einfach zwei davon.

Im Gegensatz zur Thermografie, die schon seit Jahrzehnten verfügbar ist – allerdings mit schwächerer Leistungswerten und höheren Kosten und Leistungsverlusten als die heutigen Module – ist die ToF-Technologie noch relativ neu. Sie wurde erstmals in den 1990er Jahren als akademisches Konzept vorgeschlagen, obwohl die erforderlichen Komponenten und Verarbeitungsfähigkeiten, die ihren praktischen Einsatz ermöglichen, erst im zurückliegenden Jahrzehnt entwickelt wurden.

ToF ist oftmals der bevorzugte Bildgebungsansatz für viele Anwendungen, wozu auch autonome Fahrzeuge (selbstfahrende Autos) gehören, wo es bereits auf Millionen von Straßenkilometern praktisch getestet wurde. (Was seinen Aufbau betrifft, handelt es sich bei einem intelligenten oder autonomen Fahrzeug auch nur um einen Spezialtyp eines Robotersystems auf Rädern, mit Sensoren, Algorithmen und definierten Aktionen – es kommt halt immer auf die Betrachtungsweise an.) Der ToF-Ansatz weist tatsächlich gegenüber einer herkömmlichen Bildgebungskamera einige entscheidende Vorteile auf (die wir unten erläutern wollen).

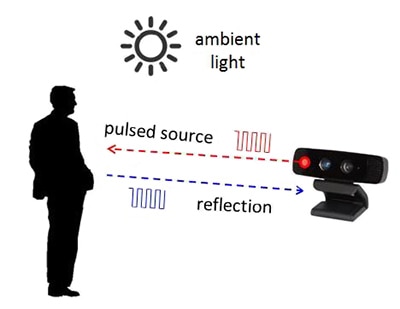

Und so funktioniert es: Im Unterschied zur herkömmlichen Kamerabilderzeugung, bei der Ingenieuren die Betriebsprinzipien im Allgemeinen bekannt und auch irgendwie verständlich sind, ist ToF weniger bekannt, und seine Implementierung beruht auf Gleichungen sowie der Erfassung von Photonen. Die beiden Hauptkomponenten bei dieser Technologie sind eine präzise gesteuerte und modulierte Lichtquelle, bei der es sich entweder um einen Festkörperlaser oder eine LED handelt (üblicherweise betrieben im IR-Nahbereich von 850 µm und damit für das menschliche Auge unsichtbar), und ein Pixel-Array zum „Sehen“ der Reflexionen des von der Lichtquelle ausgesendeten Licht von der abzubildenden Szene (Abbildung 5).

Abbildung 5: Das ToF-Konzept lässt sich ganz einfach so beschreiben: Projiziere ein gepulstes Licht auf die Szene und erfasse die reflektierten Lichtpulse und deren zurückgelegte Zeit. Dagegen ist die tatsächliche Umsetzung viel komplizierter, wenn auch heutzutage praktikabel. (Bild mit Genehmigung von Texas Instruments)

Zum vollständigen Verständnis des ToF-Prinzips sind Gleichungen erforderlich, die nicht nur dessen Betrieb definieren, sondern auch einige unvermeidliche Fehlerquellen berücksichtigen und diese kompensieren. Der ToF-Gesamtprozess kann in zwei Varianten ablaufen: Die Lichtquelle wird entweder wiederholt und mit niedrigem Betriebszyklus gepulst, oder sie wird durch eine kontinuierliche Sinus- oder Rechteckwellenquelle moduliert. Bei Verwendung des gepulsten Modus erfolgt die Abtastung der reflektierten Lichtenergie mithilfe von zwei phasenverschobenen Fenstern, und anhand dieser Abtastungen wird die Entfernung zum Ziel berechnet. Bei Verwendung des kontinuierlichen Modus erfasst der Sensor vier Abtastungen pro Messung, wobei jede Abtastung um 90° versetzt ist, woraus der Phasenwinkel zwischen Beleuchtung und Reflexion – und damit die Entfernung – berechnet werden kann.

Die Ausgabe ist eine ToF-Sequenz, und die Berechnungen sind eine Wolke von Punkten, welche die abgebildeten Bereiche repräsentiert, daher der Begriff „Punktwolke“.[1]

Relative Vor- und Nachteile: Bei der Entscheidung zwischen herkömmlicher Bildgebung mit einer oder zwei Kameras und dem ToF-Ansatz müssen einige Vor- und Nachteile je nach der konkreten Anwendung in Erwägung gezogen werden. Zur grundlegenden Inspektion und Fehlererkennung, wo das Objekt im Voraus bekannt ist und das Ziel in der Erfassung bzw. im Vergleich eines Merkmals innerhalb einer kontrollierten Beleuchtungsumgebung besteht, ist oftmals eine einzelne Kamera, die ein 2D-Bild liefert, die beste Wahl. Ist jedoch die Beleuchtung veränderlich, kann ToF besser geeignet, weil es weniger von Schwankungen des Umgebungslichts beeinflusst wird.

Bei der 3D-Bildgebung unter Einsatz von zwei herkömmlichen Kameras sind bei der Entscheidung noch mehr Dimensionen zu berücksichtigen, beginnend bei mechanischen und Montagefragen. Doch selbst wenn diese Fragen geklärt sind, muss das System, welches das Bild verarbeitet, über robuste Algorithmen verfügen, die das Problem der "Korrespondenz“ bewältigen: den Abgleich zwischen einem Punkt in der Szene von der einen Kamera mit demselben Punkt in der Szene von der zweiten Kamera. Dazu ist eine substantielle Farb- oder Graustufenabweichung erforderlich, und die Tiefengenauigkeit ist oft aufgrund einer einheitlichen Oberfläche der abzubildenden Szene beschränkt. Im Gegensatz hierzu ist ein ToF-System weniger von mechanischen Fragen wie auch Beleuchtungs- und Kontrastproblemen beeinflusst, und zur Erzeugung eines 3D-Ergebnisses benötigt es keinen Abgleich der Bildkorrespondenz.

Aufgrund ihrer kurzen Reaktionszeit und der Möglichkeit, breite Bereiche von Objektmerkmalen zu erfassen, aber auch wegen des Charakters der dabei erzeugten Punktwolke eignen sich ToF-Systeme gut für die Umsetzung von Hand-, Gesichts- oder Körpergesten in Befehle, aber auch zur Erfassung der Umgebung in autonomen Fahrzeugen. Allerdings sind Lösungen mit Verwendung von einer oder zwei herkömmlichen Kameras mit geringeren Kosten verknüpft, weil einfache Bildgebungskameras bereits im großen Umfang angeboten werden.

Implementierung: Ein ToF-System besteht aus fünf wesentlichen Funktionsblöcken:

- Lichtquelle: Eine Komponente zur Erzeugung der präzise zeitgesteuerten Lichtpulse.

- Optik: Eine Linse zur Fokussierung des Lichts auf dem Sensor; die Optik umfasst wahrscheinlich auch einen optischen Bandpassfilter zur Reduzierung des „Rauschens“ durch Umgebungslicht.

- Bildsensor: Dieser erfasst die Reflexionen des ausgesendeten Lichts, die von der beleuchteten Szene stammen.

- Ansteuerungselektronik: Sie steuert und synchronisiert die Beleuchtungseinheit und den Bildsensor.

- Berechnungseinheit und Schnittstelle: Sie berechnet die Entfernung auf Basis der Zeitsteuerung der Beleuchtung und den zurückgesendeten und erfassten Photonen.

Die Auswahl der Lichtquelle und des Bildsensors sind die ersten Schritte beim Konfigurieren eines ToF-Systems. Eine mögliche Lichtquelle ist eine Diode, wie etwa die Vishay VSMY1850X01, eine 850 μm IR-Komponente, die speziell für den Hochgeschwindigkeitsbetrieb ausgelegt ist. Bei Ansteuerung mit 100 mA unterstützt sie Anstiegs- und Abfallzeiten von 10 ns, wodurch sie sich für den Pulsmodus gut eignet.

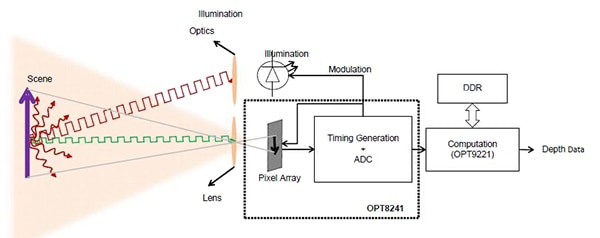

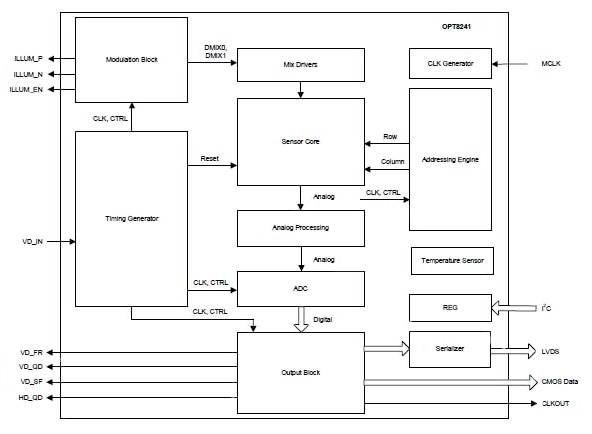

Der Sensor bzw. das Pixel-Array bildet das Herzstück des ToF-Systems und ist jetzt als Teil eines größeren, stärker integrierten Bausteins erhältlich, wie dem von Texas Instruments angebotenen OPT8241 Time-of-Flight-Sensor/Controller-IC (Abbildung 6). Er enthält die Sensorquelle (oben als Element 3 angegeben) und die Ansteuerungselektronik (Element 4), wie das in seinem vereinfachten Blockschaltbild dargestellt ist (Abbildung 7), und liefert digitalisierte Reflexionsdaten an einen Coprozessor, wie etwa den OPT9221 Time-of-Flight Controller, der aus den digitalisierten Sensordaten die Tiefendaten berechnet. Durch den OPT9221 werden auch verschiedene Korrekturfunktionen implementiert, darunter Anti-Aliasing, Nichtlinearitätskompensierung und Temperaturkompensierung.

Abbildung 6: Mit dem OPT8241 von TI in Verbindung mit dem OPT9221-Berechnungsmodul können Konstrukteure mit vertretbarem Hardware-Einsatz und relativ wenigen Komponenten ein ToF-System aufbauen.

Abbildung 7: Das vereinfachte Blockschaltbild des OPT8241 deutet die Komplexität an, die dieser zur Implementierung des ToF-Frontends verwendet; es enthält auch die Modulationssteuerung und den Treiber für die Beleuchtungs-LED. (Bild mit Genehmigung von Texas Instruments)

Wie bei jedem Videosystem, das dazu ausgelegt ist, nicht nur eine Szene zu erfassen, sondern das gleichzeitig konsistent und praktisch nutzbar bewerkstelligen soll, ist das Design der ToF-Software keine einfache Angelegenheit. TI bietet eine detailliertes Benutzerhandbuch[2] sowie ein Planungstool an, mit dem Konstrukteure die Leistung und das Wechselspiel der Parameter wie etwa Tiefenauflösung, 2D-Auflösung (Pixelzahl), Distanzbereich, Einzelbildrate, Sichtfeld (Field of View, FoV), Umgebungslicht und Reflexionsgrad des Objekts beurteilen können.

Fazit

Konstrukteure von Robotiksystemen standen schon immer vor der Herausforderung, eine detaillierte „Wahrnehmung der Umgebung“ zu liefern. Zum Glück stehen den Konstrukteuren von heute leistungsstarke und relativ kostengünstige Technologien zur Verfügung, wozu die Infrarot-Bildgebung, herkömmliche Videokameras und sogar die LIDAR-Technologie auf Basis des Laufzeitkonzepts zählen. Deshalb – und aufgrund ihres geringen Gesamtenergieverbrauchs – nutzen viele Komplettlösungen eine Kombination dieser Ansätze, um die Nachteile einer einzelnen Technik zu überwinden und um ein vollständigeres mehrdimensionales Bild zu liefern.

Referenzen:

- „Laufzeit(ToF)-Kamera – Eine Einführung“, Texas Instruments

- „Einführung in das Laufzeit(ToF)-Systemdesign“, Texas Instruments

Haftungsausschluss: Die Meinungen, Überzeugungen und Standpunkte der verschiedenen Autoren und/oder Forumsteilnehmer dieser Website spiegeln nicht notwendigerweise die Meinungen, Überzeugungen und Standpunkte der DigiKey oder offiziellen Politik der DigiKey wider.