Schneller Einstieg in 3D-Laufzeitanwendungen

Zur Verfügung gestellt von Nordamerikanische Fachredakteure von DigiKey

2020-03-25

Die 3D-Laufzeiterfassung (ToF) bietet eine effiziente Alternative zur Video-Bildgebung für ein breites Spektrum von Anwendungen, einschließlich industrieller Sicherheit, Roboternavigation, Schnittstellen zur Gestensteuerung und vieles mehr. Dieser Ansatz erfordert jedoch eine sorgfältige Mischung aus optischem Design, Präzisions-Zeitsteuerungsschaltungen und Signalverarbeitungsfunktionen, die es Entwicklern oft schwer machen, eine effektive 3D-TOF-Plattform zu implementieren.

Dieser Artikel beschreibt die Nuancen der ToF-Technologie, bevor er zeigt, wie zwei serienmäßige 3D-TOF-Kits - die Entwicklungsplattform AD-96TOF1-EBZ von Analog Devices und das EPC660-Evaluierungskit von ESPROS Photonics - Entwicklern helfen können, schnell Prototypen von 3D-TOF-Anwendungen zu erstellen und die nötige Erfahrung zu sammeln, um 3D-TOF-Designs zu implementieren, die ihre einzigartigen Anforderungen erfüllen.

Was ist die ToF-Technologie?

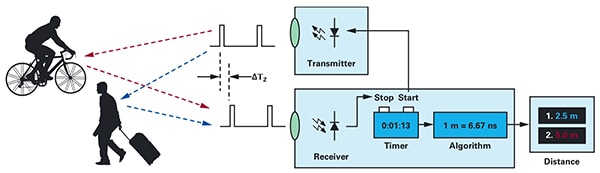

Die ToF-Technologie beruht auf dem bekannten Prinzip, dass der Abstand zwischen einem Objekt und einem Quellpunkt durch die Messung der Differenz zwischen der Zeit, in der die Energie von der Quelle ausgesendet wird, und der Zeit, in der ihre Reflexion von der Quelle empfangen wird, ermittelt werden kann (Abbildung 1).

Abbildung 1: ToF-Systeme berechnen den Abstand zwischen dem System und externen Objekten, indem sie die Zeitverzögerung zwischen der Energieübertragung und dem Empfang der von einem Objekt reflektierten Energie durch das System messen. (Bildquelle: Analog Devices)

Abbildung 1: ToF-Systeme berechnen den Abstand zwischen dem System und externen Objekten, indem sie die Zeitverzögerung zwischen der Energieübertragung und dem Empfang der von einem Objekt reflektierten Energie durch das System messen. (Bildquelle: Analog Devices)

Obwohl das Grundprinzip dasselbe bleibt, sind die ToF-Lösungen sehr unterschiedlich und tragen die Fähigkeiten und Grenzen der ihnen zugrunde liegenden Technologien wie Ultraschall, LiDAR (Light Detection and Ranging), Kameras und Millimeterwellen-HF-Signale (mmWave) in sich:

- Ultraschall-TOF-Lösungen bieten eine kostengünstige Lösung, aber mit begrenzter Reichweite und räumlicher Auflösung der Objekte

- Optische ToF-Lösungen können eine größere Reichweite und räumliche Auflösung als Ultraschallsysteme erreichen, werden aber durch starken Nebel oder Rauch beeinträchtigt.

- Lösungen, die auf der mmWave-Technologie basieren, sind in der Regel komplexer und teurer, aber sie können bei einer beträchtlichen Reichweite arbeiten und trotz Rauch, Nebel oder Regen Informationen über die Geschwindigkeit und den Kurs des Zielobjekts liefern.

Die Hersteller nutzen die Möglichkeiten der einzelnen Technologien je nach Bedarf, um spezifische Anforderungen zu erfüllen. Ultraschallsensoren eignen sich beispielsweise gut zur Erkennung von Hindernissen, wenn sich Roboter über einen Weg bewegen oder wenn Fahrer ihre Fahrzeuge parken. Im Gegensatz dazu bietet die mmWave-Technologie Fahrzeugen die Art von Langstrecken-Sensorik, die erforderlich ist, um sich nähernde Gefahren auf der Straße zu erkennen, selbst wenn andere Sensoren nicht in der Lage sind, schwere Witterungsbedingungen zu durchdringen.

ToF-Designs können um ein einziges Sender/Empfänger-Paar herum aufgebaut werden. Zum Beispiel erfordert ein einfaches optisches ToF-Design konzeptionell nur eine LED, um einen bestimmten Bereich von Interesse zu beleuchten, und eine Fotodiode, um Reflexionen von Objekten innerhalb dieses Bereichs von Interesse zu erkennen. Dieses scheinbar einfache Design erfordert jedoch präzise Zeit- und Synchronisationsschaltungen, um die Verzögerung zu messen. Darüber hinaus können Modulations- und Demodulationsschaltungen erforderlich sein, um das Beleuchtungssignal von Hintergrundquellen zu unterscheiden oder komplexere Dauerstrichverfahren zu unterstützen.

Die Designkomplexität steigt schnell an, da die Entwickler daran arbeiten, das Signal-Rausch-Verhältnis (SNR) zu verbessern und Artefakte in ToF-Systemen zu eliminieren. Um die Komplexität noch weiter zu erhöhen, werden fortschrittlichere Detektionslösungen mehrere Sender und Empfänger einsetzen, um mehrere Objekte zu verfolgen oder anspruchsvollere Algorithmen zur Bewegungsverfolgung zu unterstützen. Beispielsweise verwenden mmWave-Systeme oft mehrere Empfänger, um den Kurs und die Geschwindigkeit mehrerer unabhängiger Objekte zu verfolgen. (Siehe "Millimeterwellen-Radar-Kits für die schnelle Entwicklung von Präzisions-Objekterkennungsdesigns verwenden").

Optische 3D ToF-Systeme

Optische 3D-TOF-Systeme erweitern die Idee, mehr Empfänger zu verwenden, indem sie bildgebende Sensoren verwenden, die in der Regel auf einer Anordnung von ladungsgekoppelten Bauelementen (CCDs) basieren. Wenn ein Satz von Objektiven einen bestimmten Bereich von Interesse auf die CCD-Zeile fokussiert, wird jeder Ladungsspeicher in der CCD-Zeile durch die Rückbeleuchtung aufgeladen, die von einem entsprechenden Punkt in diesem Bereich von Interesse reflektiert wird. Synchronisiert mit gepulster oder kontinuierlicher Wellenbeleuchtung wird das reflektierte Licht, das die CCD-Zeile erreicht, im Wesentlichen in einer Folge von Fenstern bzw. Phasen erfasst. Diese Daten werden weiter verarbeitet, um eine 3D-Tiefenkarte zu erstellen, die Voxel (VOlume piXELs) enthält, deren Wert die Entfernung zum entsprechenden Punkt in der interessierenden Region darstellt.

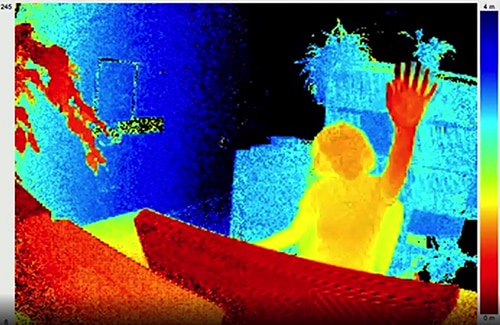

Wie die Einzelbilder in einem Video können einzelne Tiefenkarten nacheinander erfasst werden, um Messungen mit einer zeitlichen Auflösung, die nur durch die Bildfrequenz des Bilderfassungssystems begrenzt ist, und mit einer räumlichen Auflösung, die nur durch die CCD-Zeile und das optische System begrenzt ist, zu ermöglichen. Mit der Verfügbarkeit größerer CCD-Imager mit 320 x 240 Pixeln finden optische 3D-TOF-Systeme mit höherer Auflösung Anwendungen in den verschiedensten Segmenten, einschließlich Industrieautomatisierung, unbemannte Flugzeuge (UAVs) und sogar Gestenschnittstellen (Abbildung 2).

Abbildung 2: Mit ihrer hohen Bildfrequenz und räumlichen Auflösung können optische 3D-TOF-Systeme Gesten-Schnittstellensysteme mit detaillierten Daten versorgen, wie z.B. die Hand einer Person, die wie hier gezeigt in Richtung ToF-Kamera gehoben wird. (Bildquelle: ESPROS Photonics)

Abbildung 2: Mit ihrer hohen Bildfrequenz und räumlichen Auflösung können optische 3D-TOF-Systeme Gesten-Schnittstellensysteme mit detaillierten Daten versorgen, wie z.B. die Hand einer Person, die wie hier gezeigt in Richtung ToF-Kamera gehoben wird. (Bildquelle: ESPROS Photonics)

Im Gegensatz zu den meisten kamerabasierten Methoden können 3D ToF-Systeme trotz Abschattung oder wechselnden Lichtverhältnissen genaue Ergebnisse liefern. Diese Systeme bieten eine eigene Beleuchtung, wobei in der Regel Laser oder Hochleistungs-Infrarot-LEDs wie die Luxeon IR-LEDs von Lumileds verwendet werden, die mit den in diesen Systemen verwendeten Schaltraten im Megahertz-Bereich (MHz) arbeiten können. Im Gegensatz zu Methoden wie stereoskopischen Kameras bieten 3D ToF-Systeme eine kompakte Lösung zur Erzeugung detaillierter Entfernungsinformationen.

Vorgefertigte Lösungen

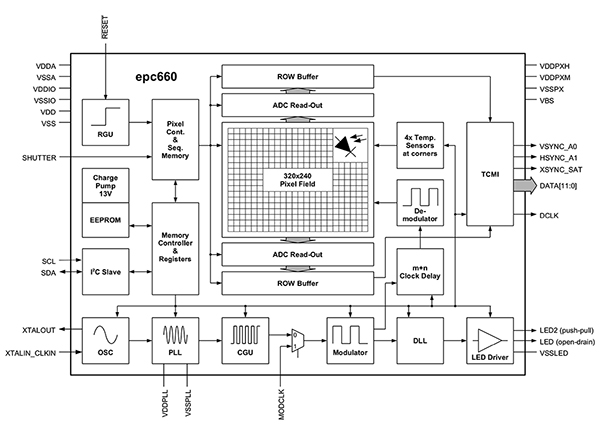

Bei der Implementierung von 3D-ToF-Systemen stehen die Entwickler jedoch vor zahlreichen Herausforderungen. Neben den bereits erwähnten Zeitschaltkreisen sind diese Systeme auf eine sorgfältig entworfene Signalverarbeitungspipeline angewiesen, die so optimiert ist, dass die Ergebnisse für jedes Fenster oder jede Phasenmessung schnell aus der CCD-Zeile ausgelesen und dann die Verarbeitung abgeschlossen wird, die erforderlich ist, um diese Rohdaten in Tiefenkarten zu verwandeln. Fortschrittliche 3D ToF-Imager wie der EPC660-CSP68-007 ToF-Imager von ESPROS Photonics kombinieren ein 320 x 240 CCD-Array mit der gesamten Palette an Timing- und Signalverarbeitungsfunktionen, die zur Durchführung von 3D ToF-Messungen und zur Bereitstellung von 12-Bit-Abstandsdaten pro Pixel erforderlich sind (Abbildung 3).

Abbildung 3: Das ESPROS Photonics epc660 integriert einen 320 x 240 Pixel grossen Imager mit einer vollständigen Palette von Zeitsteuerungsschaltungen und Controllern, die zur Umwandlung der Rohdaten des Imagers in Tiefenkarten erforderlich sind. (Bildquelle: ESPROS Photonics)

Abbildung 3: Das ESPROS Photonics epc660 integriert einen 320 x 240 Pixel grossen Imager mit einer vollständigen Palette von Zeitsteuerungsschaltungen und Controllern, die zur Umwandlung der Rohdaten des Imagers in Tiefenkarten erforderlich sind. (Bildquelle: ESPROS Photonics)

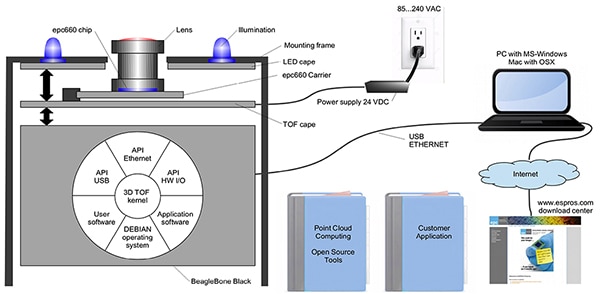

Der Chipträger EPC660-007 von ESPROS Photonics für Kartenrandverbinder montiert den epc650-Imager auf einer 37,25 x 36,00 Millimeter (mm) grossen Leiterplatte (pc board), komplett mit Entkopplungskondensatoren und Kartenrandverbinder. Obwohl dieser Chipträger die grundlegende Hardwareschnittstelle in einem 3D-TOF-System-Design anspricht, bleibt es den Entwicklern überlassen, das entsprechende optische Design am Front-End zu vervollständigen und Verarbeitungsressourcen am Back-End bereitzustellen. Das ESPROS Photonics epc660 Evaluationskit eliminiert diese Aufgaben, indem es eine vollständige 3D ToF-Anwendungsentwicklungsumgebung bereitstellt, die ein vorgefertigtes 3D ToF-Bildgebungssystem und die zugehörige Software enthält (Abbildung 4).

Abbildung 4: Das ESPROS Photonics epc660 Evaluationskit bietet ein vorgefertigtes 3D ToF-Kamerasystem und die dazugehörige Software zur Nutzung von Tiefeninformationen in Anwendungen. (Bildquelle: ESPROS Photonics)

Abbildung 4: Das ESPROS Photonics epc660 Evaluationskit bietet ein vorgefertigtes 3D ToF-Kamerasystem und die dazugehörige Software zur Nutzung von Tiefeninformationen in Anwendungen. (Bildquelle: ESPROS Photonics)

Das ESPROS-Kit wurde für die Evaluierung und das Rapid Prototyping entwickelt und bietet ein vormontiertes Kamerasystem, das den epc660 CC-Chipträger, die optische Linsenbaugruppe und einen Satz von acht LEDs kombiniert. Zusammen mit dem Kamerasystem dient eine BeagleBone Black-Prozessorkarte mit 512 Megabyte (Mbytes) RAM und 4 Gigabyte (Gbytes) Flash als Host-Controller und Ressource für die Anwendungsverarbeitung.

ESPROS bietet auch die Unterstützungssoftware epc660 eval kit an, die von der ESPROS Website heruntergeladen und mit einem Passwort geöffnet werden kann, das beim lokalen Verkaufsbüro des Unternehmens angefordert werden kann. Nach dem Zugriff auf die Software führen die Entwickler einfach eine Anwendung mit einer grafischen Benutzeroberfläche (GUI) mit einer von mehreren mitgelieferten Konfigurationsdateien aus, um mit dem Betrieb des Kamerasystems zu beginnen. Die GUI-Anwendung bietet auch Kontroll- und Anzeigefenster zur Einstellung zusätzlicher Parameter, einschließlich räumlicher und zeitlicher Filtereinstellungen und schließlich zur Anzeige der Ergebnisse. Mit minimalem Aufwand können Entwickler mit dem Kit beginnen, Tiefenkarten in Echtzeit zu erfassen und diese als Input für ihre eigene Anwendungssoftware zu verwenden.

3D ToF-Systeme mit verbesserter Auflösung

Ein 320 x 240 Bildsensor wie das ESPROS epc660 kann viele Anwendungen bedienen, aber es fehlt möglicherweise die Auflösung, die erforderlich ist, um kleine Bewegungen in Gestenschnittstellen zu erkennen oder kleine Objekte zu unterscheiden, ohne den Interessenbereich stark einzuschränken. Für diese Anwendungen stehen fertige Entwicklungskits auf der Basis von 640 x 480 ToF-Sensoren zur Verfügung, die es Entwicklern ermöglichen, schnell Prototypen von hochauflösenden Anwendungen zu erstellen.

Die DepthEye Turbo-Tiefenkamera von Seeed Technology integriert einen 640 x 480 ToF-Sensor, vier 850 Nanometer (nm) vertikal-hohlraum-emittierende Laserdioden (VCSEL), Beleuchtungs- und Sensorbetriebsschaltkreise, Stromversorgung und USB-Schnittstellenunterstützung in einem eigenständigen Würfel mit den Abmessungen 57 x 57 x 51 mm. Die Software-Unterstützung wird über ein Open-Source libPointCloud SDK github-Repository mit Unterstützung für Linux-, Windows-, Mac OS- und Android-Plattformen bereitgestellt.

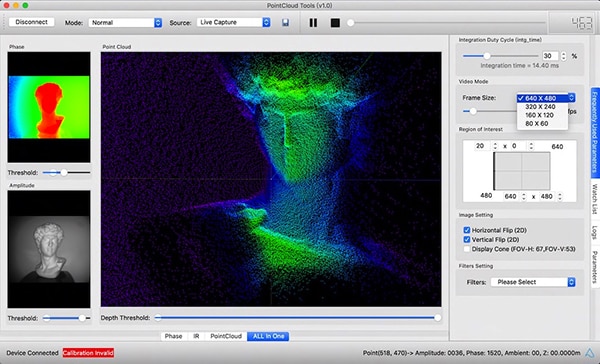

Neben C++-Treibern, Bibliotheken und Beispielcode enthält die libPointCloud SDK-Distribution eine Python-API für schnelles Prototyping sowie ein Visualisierungstool. Nach der Installation des Distributionspakets auf ihrer Host-Entwicklungsplattform können die Entwickler die Kamera über USB an ihren Computer anschließen und sofort mit der Verwendung des Visualisierungstools beginnen, um Phasen-, Amplituden- oder Punktwolkenkarten anzuzeigen, die im Wesentlichen erweiterte Tiefenkarten sind, die mit Texturoberflächen gerendert werden, um ein glatteres 3D-Bild zu erhalten (Abbildung 5).

Abbildung 5: In Kombination mit der Tiefenkamera Seeed Technology DepthEye Turbo ermöglicht das zugehörige Softwarepaket Entwicklern die einfache Visualisierung von 3D-TOF-Daten in einer Vielzahl von Renderings einschließlich Punktwolken, wie hier im Hauptfensterbereich gezeigt. (Bildquelle: Gesehene Technologie/PointCloud.AI)

Abbildung 5: In Kombination mit der Tiefenkamera Seeed Technology DepthEye Turbo ermöglicht das zugehörige Softwarepaket Entwicklern die einfache Visualisierung von 3D-TOF-Daten in einer Vielzahl von Renderings einschließlich Punktwolken, wie hier im Hauptfensterbereich gezeigt. (Bildquelle: Gesehene Technologie/PointCloud.AI)

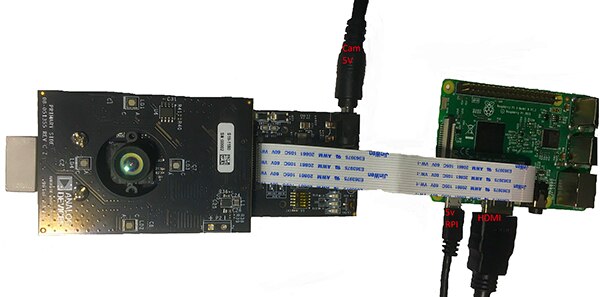

Das 3D-TOF-Evaluierungskit AD-96TOF1-EBZ von Analog Devices bietet ein offeneres Hardware-Design, das aus zwei Platinen besteht und für die Verwendung von Raspberry Pi's Raspberry Pi 3 Modell B+ oder Raspberry Pi 4 als Host-Controller und lokale Verarbeitungsressource ausgelegt ist (Abbildung 6).

Abbildung 6: Das 3D-TOF-Evaluierungskit AD-96TOF1-EBZ von Analog Devices kombiniert eine Zwei-Platinen-Baugruppe zur Beleuchtung und Datenerfassung mit einer Raspberry-Pi-Platine zur lokalen Verarbeitung. (Bildquelle: Analog Devices)

Abbildung 6: Das 3D-TOF-Evaluierungskit AD-96TOF1-EBZ von Analog Devices kombiniert eine Zwei-Platinen-Baugruppe zur Beleuchtung und Datenerfassung mit einer Raspberry-Pi-Platine zur lokalen Verarbeitung. (Bildquelle: Analog Devices)

Das analoge Front-End-Board (AFE) des Kits enthält die optische Baugruppe, das CCD-Array und die Puffer, den Firmware-Speicher und einen Prozessor, der den gesamten Kamerabetrieb einschließlich der Beleuchtungszeit, der Sensorsynchronisation und der Erzeugung der Tiefenkarte verwaltet. Die zweite Platine enthält vier 850-nm-VCSEL-Laserdioden und -Treiber und ist für den Anschluss an die AFE-Platine vorgesehen, so dass die Laserdioden die optische Baugruppe umgeben, wie in der obigen Abbildung gezeigt.

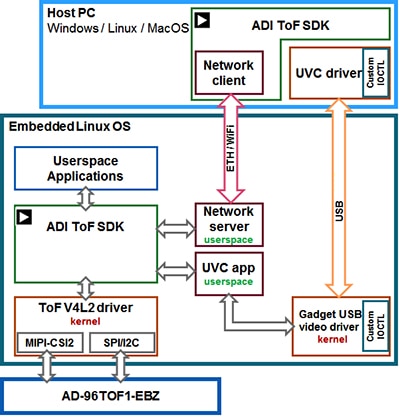

Analog Devices unterstützt das AD-96TOF1-EBZ-Kit mit seiner Open-Source-3D-TOF-Software-Suite, die das 3D-TOF-SDK zusammen mit Beispielcode und Wrappern für C/C++, Python und Matlab enthält. Um sowohl Host-Anwendungen als auch Low-Level-Hardware-Interaktionen in einer Netzwerkumgebung zu unterstützen, teilt Analog Devices das SDK in eine Host-Partition, die für USB- und Netzwerkverbindungen optimiert ist, und eine Low-Level-Partition, die unter Embedded Linux läuft und auf einem Video4Linux2 (V4L2)-Treiber aufbaut (Abbildung 7).

Abbildung 7: Die 3D ToF-SDK-API von Analog Devices unterstützt Anwendungen, die auf dem lokalen Embedded Linux-Host ausgeführt werden, sowie Anwendungen, die remote auf vernetzten Hosts ausgeführt werden. (Bildquelle: Analog Devices)

Abbildung 7: Die 3D ToF-SDK-API von Analog Devices unterstützt Anwendungen, die auf dem lokalen Embedded Linux-Host ausgeführt werden, sowie Anwendungen, die remote auf vernetzten Hosts ausgeführt werden. (Bildquelle: Analog Devices)

Dieses netzwerkfähige SDK ermöglicht es Anwendungen, die auf mit dem Netzwerk verbundenen Hosts laufen, per Fernzugriff mit einem ToF-Hardware-System zu arbeiten, um auf die Kamera zuzugreifen und Tiefendaten zu erfassen. Benutzerprogramme können auch in der Embedded-Linux-Partition ausgeführt werden und die auf dieser Ebene verfügbaren erweiterten Optionen voll ausnutzen.

Als Teil der Software-Distribution stellt Analog Devices Beispielcode zur Verfügung, der wichtige Low-Level-Betriebsfunktionen wie Kamerainitialisierung, grundlegende Bildaufnahme, Fernzugriff und plattformübergreifende Erfassung auf einem Host-Computer und lokal mit Embedded Linux demonstriert. Zusätzliche Beispielanwendungen bauen auf diesen Grundoperationen auf, um die Verwendung der erfassten Daten in übergeordneten Anwendungen wie der Punktwolkenerzeugung zu veranschaulichen. Eine Beispielanwendung zeigt, wie ein Inferenzmodell für ein tiefes neuronales Netzwerk (DNN) zur Klassifizierung der vom Kamerasystem erzeugten Daten verwendet werden kann. Diese in Python geschriebene DNN-Beispielanwendung (dnn.py) zeigt jeden Schritt des Prozesses, der für die Datenerfassung und die Vorbereitung ihrer Klassifizierung durch das Inferenzmodell (Listing 1) erforderlich ist.

Copy

import aditofpython as tof

import numpy as np

import cv2 as cv

. . .

try:

net = cv.dnn.readNetFromCaffe(args.prototxt, args.weights)

except:

print("Error: Please give the correct location of the prototxt and caffemodel")

sys.exit(1)

swapRB = False

classNames = {0: 'background',

1: 'aeroplane', 2: 'bicycle', 3: 'bird', 4: 'boat',

5: 'bottle', 6: 'bus', 7: 'car', 8: 'cat', 9: 'chair',

10: 'cow', 11: 'diningtable', 12: 'dog', 13: 'horse',

14: 'motorbike', 15: 'person', 16: 'pottedplant',

17: 'sheep', 18: 'sofa', 19: 'train', 20: 'tvmonitor'}

system = tof.System()

status = system.initialize()

if not status:

print("system.initialize() failed with status: ", status)

cameras = []

status = system.getCameraList(cameras)

. . .

while True:

# Capture frame-by-frame

status = cameras[0].requestFrame(frame)

if not status:

print("cameras[0].requestFrame() failed with status: ", status)

depth_map = np.array(frame.getData(tof.FrameDataType.Depth), dtype="uint16", copy=False)

ir_map = np.array(frame.getData(tof.FrameDataType.IR), dtype="uint16", copy=False)

# Creation of the IR image

ir_map = ir_map[0: int(ir_map.shape[0] / 2), :]

ir_map = np.float32(ir_map)

distance_scale_ir = 255.0 / camera_range

ir_map = distance_scale_ir * ir_map

ir_map = np.uint8(ir_map)

ir_map = cv.cvtColor(ir_map, cv.COLOR_GRAY2RGB)

# Creation of the Depth image

new_shape = (int(depth_map.shape[0] / 2), depth_map.shape[1])

depth_map = np.resize(depth_map, new_shape)

distance_map = depth_map

depth_map = np.float32(depth_map)

distance_scale = 255.0 / camera_range

depth_map = distance_scale * depth_map

depth_map = np.uint8(depth_map)

depth_map = cv.applyColorMap(depth_map, cv.COLORMAP_RAINBOW)

# Combine depth and IR for more accurate results

result = cv.addWeighted(ir_map, 0.4, depth_map, 0.6, 0)

# Start the computations for object detection using DNN

blob = cv.dnn.blobFromImage(result, inScaleFactor, (inWidth, inHeight), (meanVal, meanVal, meanVal), swapRB)

net.setInput(blob)

detections = net.forward()

. . .

for i in range(detections.shape[2]):

confidence = detections[0, 0, i, 2]

if confidence > thr:

class_id = int(detections[0, 0, i, 1])

. . .

if class_id in classNames:

value_x = int(center[0])

value_y = int(center[1])

label = classNames[class_id] + ": " + \

"{0:.3f}".format(distance_map[value_x, value_y] / 1000.0 * 0.3) + " " + "meters"

. . .

# Show image with object detection

cv.namedWindow(WINDOW_NAME, cv.WINDOW_AUTOSIZE)

cv.imshow(WINDOW_NAME, result)

# Show Depth map

cv.namedWindow(WINDOW_NAME_DEPTH, cv.WINDOW_AUTOSIZE)

cv.imshow(WINDOW_NAME_DEPTH, depth_map)

Listing 1: Dieser Ausschnitt aus einer Beispielanwendung der Analog Devices 3D ToF SDK-Distribution demonstriert die wenigen Schritte, die erforderlich sind, um Tiefen- und IR-Bilder zu erfassen und sie mit einem Inferenzmodell zu klassifizieren. (Codequelle: Analog Devices)

Hier beginnt der Prozess mit der Verwendung von OpenCVs DNN-Methoden (cv.dnn.readNetFromCaffe), um das Netzwerk und die zugehörigen Gewichte für ein vorhandenes Inferenzmodell zu lesen. In diesem Fall handelt es sich bei dem Modell um eine Caffe-Implementierung des Google MobileNet Single Shot Detector (SSD)-Erkennungsnetzwerks, das dafür bekannt ist, mit relativ kleinen Modellgrößen eine hohe Genauigkeit zu erreichen. Nach dem Laden der Klassennamen mit den unterstützten Klassenkennungen und Klassenbezeichnungen identifiziert die Beispielanwendung die verfügbaren Kameras und führt eine Reihe von Initialisierungsroutinen aus (nicht in Listing 1 dargestellt).

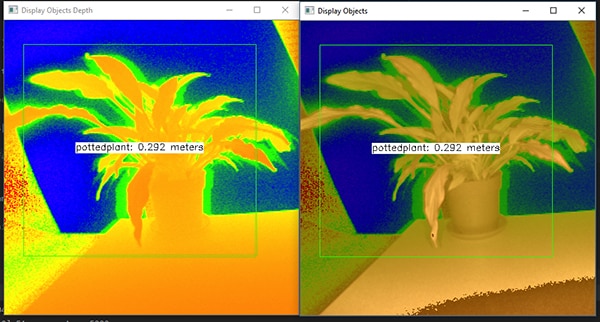

Der größte Teil des Beispiel-Codes befasst sich mit der Vorbereitung der Tiefenkarte (depth_map) und der IR-Karte (ir_map), bevor diese (cv.addWeighted) zur Erhöhung der Genauigkeit zu einem einzigen Array kombiniert werden. Schließlich ruft der Code eine weitere OpenCV-DNN-Methode (cv.dnn.blobFromImage) auf, die das kombinierte Bild in den für die Inferenz erforderlichen vierdimensionalen Blob-Datentyp konvertiert. Die nächste Codezeile legt den resultierenden Blob als Eingabe für das Inferenzmodell fest (net.setInput(blob)). Der Aufruf von net.forward() ruft das Inferenzmodell auf, das die Klassifizierungsergebnisse zurückgibt. Der Rest der Beispielanwendung identifiziert Klassifikationsergebnisse, die einen voreingestellten Schwellenwert überschreiten, und generiert für diese ein Etikett und ein Begrenzungskästchen, die die erfassten Bilddaten, das durch das Inferenzmodell identifizierte Etikett und dessen Abstand zur Kamera anzeigen (Abbildung 8).

Abbildung 8: Mit Hilfe einiger Zeilen Python-Code und der OpenCV-Bibliothek erfasst die DNN-Beispielanwendung in der 3D ToF SDK-Verteilung von Analog Devices Tiefenbilder, klassifiziert sie und zeigt die Bezeichnung und den Abstand des identifizierten Objekts an. (Bildquelle: Analog Devices)

Abbildung 8: Mit Hilfe einiger Zeilen Python-Code und der OpenCV-Bibliothek erfasst die DNN-Beispielanwendung in der 3D ToF SDK-Verteilung von Analog Devices Tiefenbilder, klassifiziert sie und zeigt die Bezeichnung und den Abstand des identifizierten Objekts an. (Bildquelle: Analog Devices)

Wie die DNN-Beispielanwendung von Analog Devices zeigt, können Entwickler 3D-ToF-Tiefenkarten in Kombination mit Methoden des maschinellen Lernens verwenden, um anspruchsvollere Anwendungsfunktionen zu erstellen. Obwohl Anwendungen, die Antworten mit geringer Latenzzeit erfordern, diese Funktionen eher mit C/C++ aufbauen, bleiben die grundlegenden Schritte gleich.

Mit Hilfe von 3D-TOF-Daten und hochleistungsfähigen Inferenzmodellen können Industrierobotersysteme ihre Bewegungen sicherer mit anderen Geräten oder sogar mit Menschen in "Cobot"-Umgebungen synchronisieren, in denen Mensch und Roboter kooperativ in enger Nachbarschaft arbeiten. Mit verschiedenen Inferenzmodellen kann eine andere Anwendung eine hochauflösende 3D-TOF-Kamera verwenden, um feine Bewegungen für eine Gestenschnittstelle zu klassifizieren. Bei Anwendungen im Automobilbereich kann der gleiche Ansatz dazu beitragen, die Genauigkeit von fortschrittlichen Fahrerassistenzsystemen (ADAS) zu verbessern, indem die hohe zeitliche und räumliche Auflösung, die mit 3D-ToF-Systemen möglich ist, voll ausgenutzt wird.

Fazit

ToF-Technologien spielen eine Schlüsselrolle in fast jedem System, das entscheidend von der genauen Messung des Abstands zwischen dem System und anderen Objekten abhängt. Unter den ToF-Technologien kann die optische 3D-TOF sowohl eine hohe räumliche als auch eine hohe zeitliche Auflösung bieten, wodurch eine feinere Unterscheidung zwischen kleineren Objekten und eine genauere Überwachung ihres relativen Abstands ermöglicht wird.

Um die Vorteile dieser Technologie nutzen zu können, mussten die Entwickler jedoch mehrere Herausforderungen bewältigen, die mit dem optischen Design, der präzisen Zeitsteuerung und der synchronisierten Signalerfassung dieser Systeme verbunden sind. Wie gezeigt, beseitigt die Verfügbarkeit von vorgefertigten 3D-TOF-Systemen, wie die Entwicklungsplattform AD-96TOF1-EBZ von Analog Devices und das ESPROS Photonics EPC660-Evaluierungskit, diese Hindernisse für die Anwendung dieser Technologie in industriellen Systemen, Gestenschnittstellen, Kfz-Sicherheitssystemen und mehr.

Haftungsausschluss: Die Meinungen, Überzeugungen und Standpunkte der verschiedenen Autoren und/oder Forumsteilnehmer dieser Website spiegeln nicht notwendigerweise die Meinungen, Überzeugungen und Standpunkte der DigiKey oder offiziellen Politik der DigiKey wider.